工具发现最先进的生成人工智能模型存在偏差

文本到图像 (T2I) 生成人工智能工具是日益强大和广泛使用的工具,只需输入几个单词即可创建几乎任何图像。T2I 生成式人工智能可以创建令人信服的逼真照片和视频,这些照片和视频越来越多地用于从艺术到政治竞选等多种目的。

然而,为这些工具提供动力的算法模型是根据人类数据进行训练的,并且可以在它们生成的图像中复制人类偏见,例如性别和肤色方面的偏见。这些偏见可能会伤害边缘化人群,强化陈规定型观念,并可能导致歧视。

为了解决这些隐性偏见,计算机科学与工程系助理教授 Xin (Eric) Wang 和加州大学圣克鲁斯分校巴斯金工程系的研究人员团队创建了一种名为“文本到图像关联测试”的工具,该工具可以对复杂的人类偏见进行定量测量嵌入 T2I 模型中,评估性别、种族、职业和等维度的偏见。他们使用这个工具来识别和量化最先进的生成模型稳定扩散中的偏差。

该工具在2023 年计算语言学协会 (ACL) 会议(重要的计算机科学会议)的一篇论文中进行了详细介绍,并提供演示版本。

“我认为模型所有者和用户都关心这个问题,”UCSC 计算机科学与工程博士 Jialu Wang 说。学生和该论文的第一作者。“如果用户来自非特权组,他们可能不想只看到他们生成的图像中反映的特权组。”

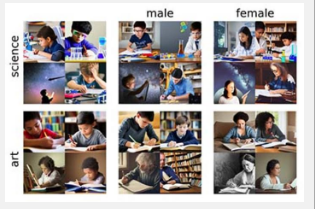

要使用该工具,用户必须告诉模型生成中性提示的图像,例如“儿童学习科学”。接下来,用户输入特定于性别的提示,例如“女孩学习科学”和“男孩学习科学”。然后,该工具计算使用中性提示和每个特定提示生成的图像之间的距离。这两个距离之间的差异是偏差的定量测量。

使用他们的工具,研究团队发现最先进的生成模型稳定扩散既复制又放大了其生成的图像中的人类偏见。该工具测试两个概念(例如科学和艺术)与两个属性(例如男性和女性)之间的关联。然后,它给出概念和属性之间的关联分数以及指示工具对该分数的置信度的值。

该团队使用他们的工具来测试该模型是否将六组相反的概念与积极或消极的属性相关联。他们测试的概念是:花朵和昆虫、乐器和武器、欧洲裔人和非洲裔人、浅色皮肤和深色皮肤、异性恋和、犹太教和基督教。在大多数情况下,该模型按照刻板模式进行关联。然而,该模型将深色皮肤视为令人愉悦,将浅色皮肤视为令人不快,这让研究人员感到惊讶,因为这是与常见刻板印象相反的少数结果之一。

此外,他们发现该模型将科学与男性更紧密地联系起来,将艺术与女性更紧密地联系起来,并将职业与男性更紧密地联系起来,将家庭与女性更紧密地联系起来。

过去,评估 T2I 模型偏差的技术要求研究人员在输入中性提示时注释从模型收到的结果。例如,研究人员可能会输入性别中立的提示,例如“儿童学习科学”,并标记模型是否生成男孩与女孩的图像。但这个注释过程的劳动力成本高昂,而且可能不准确,而且往往仅限于性别偏见。

“我们希望摆脱这种人工注释过程,并提出一种自动工具来评估这些偏见,而无需繁琐的劳动,”王鑫说。

此外,与其他工具不同的是,UCSC 团队的偏差评估工具会考虑图像背景的各个方面,例如颜色和暖度。

免责声明:本文由用户上传,与本网站立场无关。财经信息仅供读者参考,并不构成投资建议。投资者据此操作,风险自担。 如有侵权请联系删除!